Crystal-Rose Jones

Nếu Internet là thế giới thực thì cuộc sống có lẽ rất giống một bộ phim khoa học viễn tưởng, nơi robot đã chiếm lấy hành tinh, hoặc ít nhất là bắt đầu sống cùng con người.

Một dấu hiệu rõ ràng của sự hỗn độn này giữa thế giới hữu cơ và thế giới robot là những hình ảnh phi lý do trí tuệ nhân tạo (AI) tạo ra đang xuất hiện trên các tài khoản mạng xã hội.

Một số hình ảnh có cảnh những chú chó con đang say ngủ trong chiếc hộp dưới trời mưa, kêu gọi người dùng chia sẻ.

Những hình ảnh khác cho thấy những em bé trong cảnh nghèo đói cùng cực hoặc ở vùng chiến sự.

Khi xem xét kỹ hơn, thỉnh thoảng những “em bé” này sẽ có ba chân, sáu ngón tay, hoặc hai cái mũi — đây hậu quả do một AI có thể lưu trữ thông tin nhưng lại thiếu sự hiểu biết như con người về kết cấu của một cơ thể [người] thực thụ.

Rồi còn có những tác phẩm của AI mà không hề cố gắng ngụy trang bản thân như những con chó con vô gia cư hay những đứa trẻ buồn bã — ví dụ, như hình ảnh “Chúa Jesus tôm” kỳ cục.

Những hình ảnh về Chúa Jesus được ghép lại bằng mấy con tôm theo nhiều cách khác nhau đã bắt đầu tràn ngập trên mạng xã hội, đạt được số lượng chia sẻ, lượt thích, và bình luận cao chót vót theo cách mà một số người hiện hay gọi là “hack lượt giao tiếp.”

Những người bạn trên mạng xã hội của quý vị là con người hay bot AI?

Cụ thể, một AI tạo ra một hình ảnh nhằm tác động đến cảm xúc của mọi người, hoặc khai thác nhu cầu bình luận hoặc giao tiếp của người ta bằng cách tạo ra tranh cãi hoặc chủ đề thảo luận. Những hình ảnh này được bình luận bởi các tài khoản AI khác trong một diễn đàn do robot điều hành, do các robot lập nên và dành cho các robot khác.

Trong trường hợp của hình ảnh Chúa Jesus tôm, mức độ phi lý siêu thực của các bức ảnh đã tạo ra vô số lượt “thích” và tương tác, làm tăng uy tín cho các tài khoản đăng các bức ảnh này, và đánh lừa để thuật toán Facebook nghĩ rằng những tấm ảnh này là một nguồn tạo ra lượt giao tiếp có giá trị.

Câu hỏi đặt ra cho mọi người là liệu động cơ của việc này chỉ đơn giản là tạo ra doanh thu quảng cáo qua việc đẩy mạnh các tài khoản đó bằng phép thuật kỹ thuật số như vậy, hay có lẽ là còn nhiều hơn thế nữa.

Rõ ràng là một số nền tảng truyền thông đang nhận ra mối nguy hại từ các bot AI.

Trong cuộc bầu chọn cho Cuộc thi Ca khúc Eurovision 2024, người xem được yêu cầu bỏ phiếu bằng cách nộp một khoản phí nhỏ qua thẻ ngân hàng — một bước tiến tương đối mới trong cuộc thi bình chọn ca khúc này.

Đây cũng là khái niệm trái ngược với suy nghĩ của ông Elon Musk về việc tính phí sử dụng nền tảng truyền thông xã hội X, trước đây là Twitter.

Sự giao tiếp của bot đã trở thành mối đe dọa lớn đến mức nhiều nền tảng đang tìm cách chứng minh rằng lực lượng đằng sau một quy trình trên máy điện toán là con người — và trong một số trường hợp, việc này tỏ ra khá khó khăn.

Nhà khoa học: Con người dễ bị ảnh hưởng

Ông Ian Oppermann là nhà khoa học dữ liệu đứng đầu của chính phủ tiểu bang New South Wales, Úc, và ông cho biết tình cảnh này là một ví dụ điển hình về một cuộc chạy đua kỹ thuật số, trong đó trí tuệ nhân tạo (AI) có thể vừa là nguyên nhân, vừa là giải pháp cho vấn đề.

Ông nói rằng “lượt thích” là một cách đơn giản để mọi người thể hiện sự quan tâm trong không gian kỹ thuật số, và hầu hết các mạng xã hội đều giả định rằng lượt thích đến từ con người.

Ông Oppermann nói với The Epoch Times, không giống như robot, con người là “những sinh vật bầy đàn,” và đây là điều khiến họ dễ bị thao túng.

Sự thao túng đó có thể tác động đến việc mua một sản phẩm, hoặc có thể ảnh hưởng đến kết quả của một cuộc bầu cử.

Nhiều lượt “thích” hơn trên một trang có nghĩa là trang đó dường như được nhiều người dùng nhìn thấy hơn, và sản phẩm hoặc dịch vụ được đánh giá cao sẽ thu hút nhiều khách hàng hơn — có nghĩa là cuộc đua này đang diễn ra để thu hút sự chú ý của con người trong thế giới ảo.

Thực tế là lượt thích này có thể bị làm giả, do đó những đại công ty công nghệ có lẽ cần phải bắt đầu xem xét các lượt thích “đã được chứng minh tôi không phải robot,” bằng cách yêu cầu người dùng đánh dấu vào một ô hoặc chọn các hình ảnh.

“Nhưng cuối cùng AI cũng sẽ vượt qua được những rào cản này,” ông Oppermann nói. “Điều này khiến [chúng ta] phải suy nghĩ lại cách mà mọi người có thể dễ dàng thể hiện sự đánh giá hoặc sự ít hài lòng mà có thể dễ dàng nhận ra liệu một đánh giá hoặc loạt ‘lượt thích’ là giả mạo.”

Về lý thuyết, AI có thể được phát triển để phát hiện và loại bỏ các lượt thích giả mạo, hoặc cung cấp các biện pháp ngăn cản việc sử dụng các thuật toán tăng [lượt giao tiếp và hiển thị] bằng AI.

Một thập niên nghiên cứu về thao túng trực tuyến

Sử dụng AI trong việc thao túng con người có thể sẽ là một cuộc thảo luận mới, nhưng việc này cũng là một lý thuyết khoa học đã cũ.

Vào năm 2012, Facebook đã tiến hành một nghiên cứu kéo dài một tuần để kiểm tra việc thao túng các bảng tin (newsfeed) dựa trên cảm xúc của con người.

Các kết quả đã được công bố hai năm sau đó trên tạp chí Proceedings of the National Academy of Sciences.

Nghiên cứu này đã chọn ngẫu nhiên gần 700,000 người dùng và phát hiện ra rằng việc thay đổi thuật toán để hiển thị cho người dùng các bài đăng tích cực hoặc tiêu cực từ những người bạn của họ đã dẫn đến tâm trạng của họ bị nội dung mà họ tiếp xúc chi phối.

Cuối cùng, nghiên cứu này kết luận rằng các bài đăng tích cực được phản ánh trong các bài đăng vui vẻ hơn của những người dùng này, trong khi việc tiếp xúc với những nội dung tiêu cực cũng khiến họ đăng nhiều bài tiêu cực hơn.

Ông Oppermann cho biết con người rất dễ bị ảnh hưởng bởi “những cú huých tinh vi” và đặc biệt là hình ảnh có thể gây tác động đến con người, thậm chí hơn cả lời nói.

“Việc kiểm soát giới truyền thông và những thông điệp từ lâu đã được sử dụng để gây ảnh hưởng dư luận,” ông chia sẻ.

“Việc thao túng thuật toán để điều chỉnh những gì mọi người xem được (hoặc không xem được) là một cách rất hiệu quả để gây ảnh hưởng đến thế giới quan của ai đó.

“Nếu việc này có thể được cá nhân hóa nhiều hơn, thì có thể gây ảnh hưởng đến quan điểm về bất kỳ chủ đề hay vấn đề nào.”

Bóng ma thông tin giả do AI tạo ra xung quanh cuộc bầu cử ở Liên minh Âu Châu

Trong khi cư dân mạng đang tương tác với những hình ảnh quái dị trên Facebook, thì tác động thực tế của chính công nghệ đó đã khiến các chuyên gia ở châu Âu phải mất ngủ nhiều đêm.

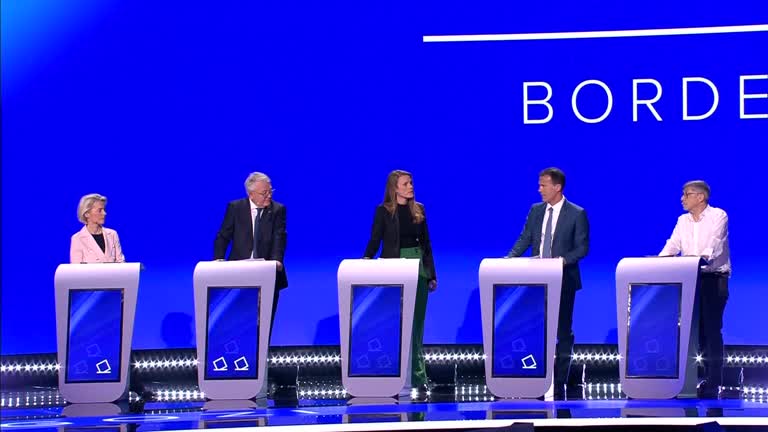

Các cử tri ở Liên minh Âu châu (EU) đã bầu chọn các nhà lập pháp từ ngày 06 đến 09/06, với mối đe dọa về việc thông tin giả trực tuyến đang ngày càng gia tăng.

Theo AAP, trước thực trạng này, nhà chính sách đối ngoại hàng đầu của EU, ông Josep Borrell, đã đưa ra một cảnh báo, cho rằng Nga đã sử dụng các chiến dịch do nhà nước tài trợ để làm cho không gian thông tin của EU tràn ngập nội dung lừa đảo.

Hoạt động này là điều mà ông Borrell coi là một mối đe dọa thực sự đối với trạng thái dân chủ, với các chiến dịch AI rẻ tiền nhắm vào các nhà lãnh đạo từng chỉ trích Tổng thống Nga Vladimir Putin.

Mặc dù có vẻ như mối đe dọa từ AI đã trở nên phổ biến, nhưng theo các chuyên gia, giải pháp cho việc này không phải là tin vào mọi thứ theo giá trị bề mặt.

Ông Oppermann cho biết: “Không sử dụng mạng xã hội là một lựa chọn, tuy nhiên, nếu đó là một nước đi quá đột ngột, thì việc kiểm tra chéo với các nguồn khác, không có mối liên quan (và hy vọng là có các ý kiến thiên lệch khác nhau) luôn là một ý tưởng hay.”

Các bước giải quyết của cơ quan quản lý

Năm ngoái, một biện lý ở Hoa Kỳ đã bị phạt vì lừa dối tòa án khi sử dụng AI bot ChatGPT để điều tra một vụ án.

Tại Hồng Kông, một nhân viên tài chính đã bị lừa trong một vụ lừa đảo deepfake, mà trong đó, “những người khác” trong cuộc gọi hội nghị video đều là AI.

Việc xác định các tác hại tiềm ẩn và khả năng đảo ngược là hai yếu tố cốt lõi của Khuôn khổ Bảo hiểm AI của New South Wales (NSW).

Hai năm trước, khung này đã trở thành bắt buộc đối với tất cả các dự án có chứa yếu tố AI hoặc sử dụng các công cụ do AI điều khiển.

Trong những ngày gần đây, chính phủ Úc đã đưa ra luật deepfake, quy định rằng hành vi phát tán hình ảnh và nội dung khiêu dâm giả mạo bằng AI sẽ bị phạt tù lên đến 7 năm.

Trong khi đó, các cơ quan quản lý của Hoa Kỳ vừa tiến hành các cuộc điều tra về vai trò của Nvidia, Microsoft, và OpenAI trong việc phát triển AI.

Ông Oppermann cho biết phải tuyệt đối ghi nhớ rằng AI tập trung vào việc sử dụng dữ liệu.

Ông ấy tin rằng Khung Bảo hiểm AI của NSW mà ông ấy đang nghiên cứu sẽ khám phá ra những rủi ro và biện pháp giảm thiểu có liên quan.

Tất cả đều liên quan đến thông tin và cách thông tin này được sử dụng — cụ thể là việc sử dụng dữ liệu trong AI, và những ý kiến thiên lệch liên quan đến thuật toán (AI).

Năm ngoái, Bộ trưởng Công nghiệp và Khoa học Ed Husic đã công bố lời khuyên từ Hội đồng Khoa học và Công nghệ Quốc gia Úc (NSTC) cũng như một bài thảo luận về AI, cho biết đã đến lúc bắt đầu xem xét các bước giải quyết tiếp theo.

Hiệp hội Ngành Thông tin Úc cho biết họ tin rằng các tổ chức nên tự điều chỉnh luật AI trong trường hợp không có luật của chính phủ, trong khi đó, chính phủ cũng nên đóng vai trò trợ giúp và thông qua các giải pháp.

Tuệ Minh biên dịch